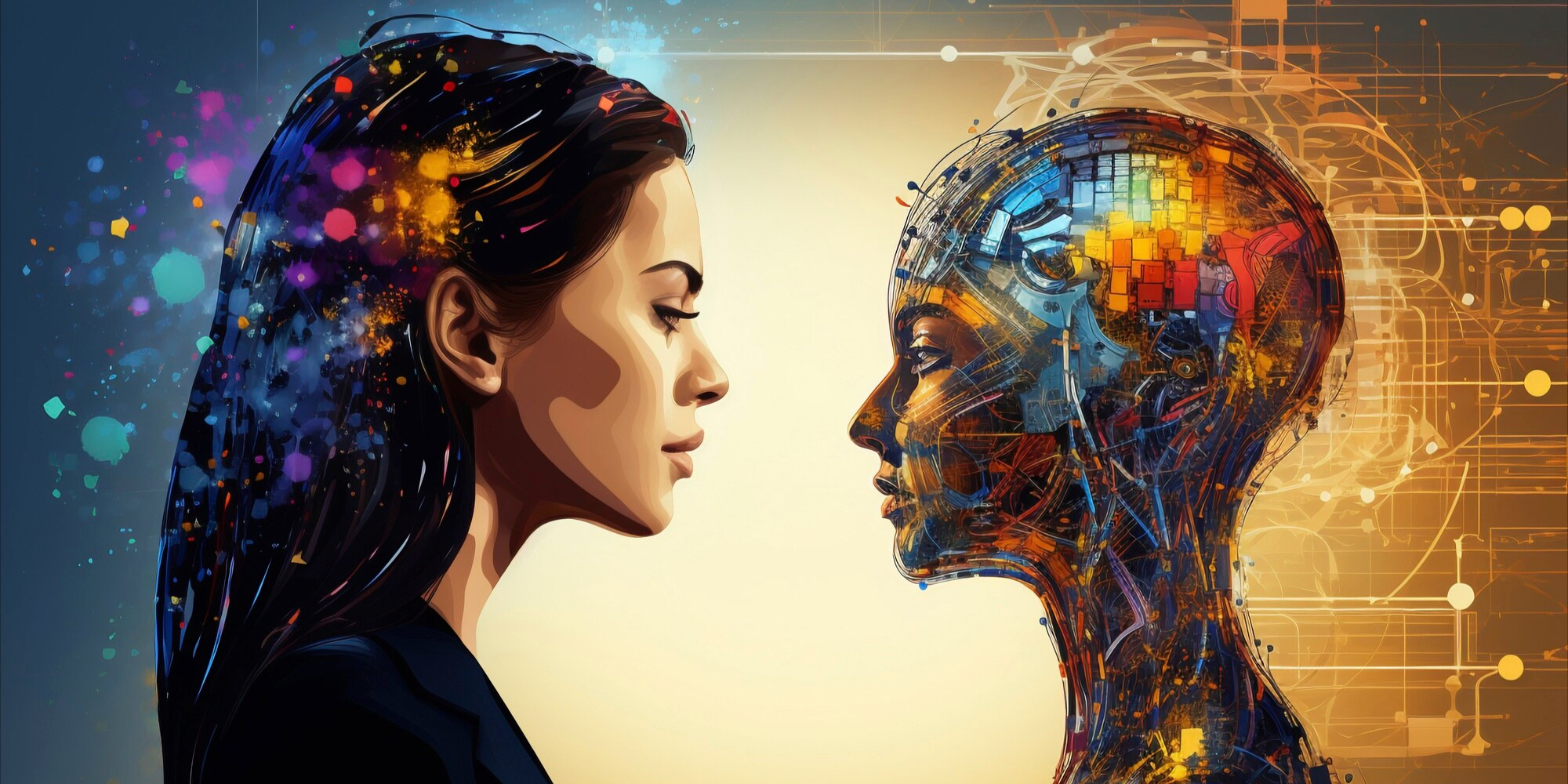

Ηθική Νοημοσύνη: Το Ανθρώπινο Αντίβαρο στην Τεχνητή Ευφυΐα

Η τεχνητή νοημοσύνη (AI) διαμορφώνει εκ νέου τον κόσμο μας με εντυπωσιακή ταχύτητα, εισβάλλοντας σε τομείς όπως η υγεία, η εκπαίδευση, η επιχειρηματικότητα και η δημόσια διοίκηση. Όσο όμως πιο περίπλοκα και αυτόνομα γίνονται τα συστήματα AI, τόσο εντονότερα αναδύεται η ανάγκη για έναν νέο πυλώνα αξιολόγησης: την ηθική ακεραιότητα των αλγορίθμων και των δημιουργών τους.

Η "τεχνητή ακεραιότητα" δεν είναι μια ουτοπική προσδοκία. Είναι μια πρακτική ανάγκη. Καθώς οι αλγόριθμοι λαμβάνουν όλο και περισσότερες αποφάσεις που επηρεάζουν ανθρώπινες ζωές – από εγκρίσεις δανείων έως ιατρικές διαγνώσεις – γίνεται σαφές ότι η τεχνολογία από μόνη της δεν αρκεί. Αυτό που χρειάζεται είναι ένα σύνολο αξιών, ένα φίλτρο ηθικής κρίσης που θα εξισορροπεί την ισχύ των υπολογιστικών μοντέλων με τις αρχές της κοινωνικής δικαιοσύνης, της διαφάνειας και του σεβασμού των ανθρωπίνων δικαιωμάτων.

ΔΕΙΤΕ ΕΔΩ ΟΛΑ ΤΑ ΣΕΜΙΝΑΡΙΑ ΓΙΑ SOFT SKILLS

Ποιος, όμως, φέρει την ευθύνη για την ακεραιότητα της τεχνητής νοημοσύνης; Η απάντηση είναι σύνθετη. Οι προγραμματιστές, οι ηγέτες των επιχειρήσεων, οι πολιτικοί, αλλά και οι ίδιοι οι χρήστες συμμετέχουν – άμεσα ή έμμεσα – στη διαμόρφωση ενός τεχνολογικού μέλλοντος που θα βασίζεται στην εμπιστοσύνη. Η δημιουργία ηθικών πλαισίων χρήσης της AI δεν μπορεί να είναι προαιρετική ή να έπεται των εξελίξεων. Πρέπει να προηγείται και να ενσωματώνεται στη φάση του σχεδιασμού.

Η ηθική, όμως, δεν μπορεί να προγραμματιστεί με γραμμικό τρόπο. Δεν είναι απλώς ένα υποσύνολο εντολών ή ένας αλγόριθμος «τύπου Google». Είναι μια δυναμική διαδικασία που απαιτεί κρίση, ευαισθησία, προσαρμοστικότητα. Η έννοια της "τεχνητής ακεραιότητας" ίσως να είναι παραπλανητική, καθώς η ακεραιότητα δεν είναι ιδιότητα των μηχανών, αλλά των ανθρώπων. Ωστόσο, αυτό που μπορούμε να επιδιώξουμε είναι η τεχνολογική μεταφορά ηθικής πρόθεσης: να ενσωματώσουμε στον σχεδιασμό των συστημάτων τις αξίες που εμείς θεωρούμε θεμελιώδεις.

ΔΕΙΤΕ ΕΔΩ ΟΛΑ ΤΑ ΣΕΜΙΝΑΡΙΑ ΓΙΑ ΕΠΑΓΓΕΛΜΑΤΙΕΣ ΠΛΗΡΟΦΟΡΙΚΗΣ

Η λύση δεν βρίσκεται μόνο στον κώδικα, αλλά και στην εκπαίδευση των επαγγελματιών τεχνολογίας, στην πολυφωνία των ομάδων ανάπτυξης, στη διαφάνεια των αλγορίθμων και, φυσικά, στη δημόσια λογοδοσία. Ο ηθικός έλεγχος της τεχνολογίας είναι ζήτημα συλλογικής ευθύνης και όχι ατομικής επιλογής.

Επιπλέον, η τεχνητή νοημοσύνη δεν είναι αποκομμένη από τα κοινωνικά μας στερεότυπα. Αν εκπαιδεύσουμε ένα σύστημα με δεδομένα που φέρουν προκαταλήψεις, τότε αυτές οι προκαταλήψεις θα αναπαραχθούν και θα ενισχυθούν. Η ακεραιότητα απαιτεί λοιπόν προσοχή, όχι μόνο στον τρόπο λειτουργίας ενός αλγορίθμου, αλλά και στα δεδομένα που τον τροφοδοτούν.

ΔΕΙΤΕ ΕΔΩ ΟΛΑ ΤΑ ΣΕΜΙΝΑΡΙΑ ΓΙΑ MANAGEMENT & LEADERSHIP

Καθώς προχωρούμε σε ένα μέλλον όπου η συνεργασία ανθρώπου και μηχανής θα είναι αναπόφευκτη, οφείλουμε να διασφαλίσουμε ότι η ηθική μας δεν μένει πίσω από την πρόοδό μας. Δεν πρόκειται για ηθική πολυτέλεια, αλλά για αναγκαία προϋπόθεση αξιοπιστίας, βιωσιμότητας και ανθρωποκεντρικού σχεδιασμού.

Η τεχνητή νοημοσύνη μπορεί να είναι ταχύτερη, ακριβέστερη και πιο αποδοτική από τον άνθρωπο. Δεν πρέπει όμως να είναι λιγότερο ηθική. Διότι στο τέλος της ημέρας, η ποιότητα του ψηφιακού μας μέλλοντος θα εξαρτηθεί όχι μόνο από το τι μπορούν να κάνουν οι μηχανές, αλλά από το τι επιλέγουμε εμείς να τους επιτρέψουμε να κάνουν.

Share:

Διαβάστε Επίσης

Σήμερα η κοινωνική ευαισθητοποίηση γύρω από τον ρατσισμό, τον σεξισμό και την ισότητα γνωρίζει μεγάλη πρόοδο.

Το 2025, έχει εξελιχθεί σε καθημερινό εργαλείο που ενισχύει την προσωπική εξέλιξη

Ελληνικά

Ελληνικά  English

English